논문링크 : Squeeze-and-Excitation Networks

핵심 아이디어 : 컨볼루션을 통해 생성된 특성을 채널당 중요도를 고려해서 재보정(recalibration)하는 것.

2018년 CVPR에서 발표, SENet은 2017년 이미지넷 대회에서 우승을 차지한 모델. top-5 error가 2.251% (ground-truth인 사람의 top-5 error가 5%, 이는 해당 데이터셋에 대해 사람보다 이미지 분류를 더 잘 한다는 뜻)

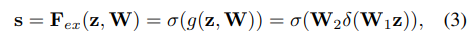

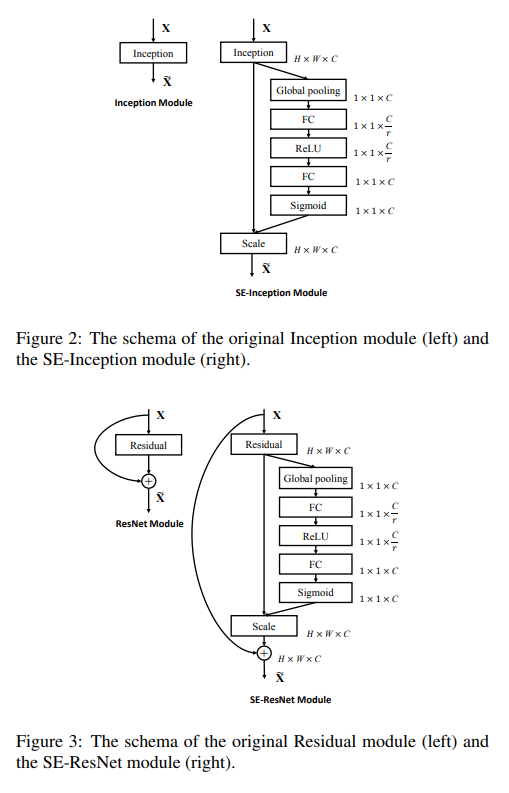

기존 어떤 모델에도 적용될 수 있는 SE block이라는 것을 제안, VGGNet, GoogLeNet, ResNet 등에 SE block을 첨가함으로써 성능 향상을 도모할 수 있음. 성능은 꽤 많이 향상되는 반면, hyperparameter는 많이 늘지 않기 때문에, 연산량 증가는 크지 않다. (Contribution)

SE block

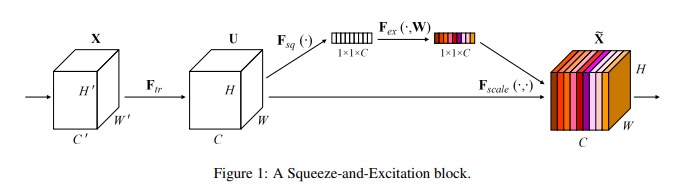

- [Figure 1]에서 X, U는 특성맵, \(F_{tr}\)은 컨볼루션 연산, H'xW'xC' 크기의 특성맵 X가 HxWxC 크기의 특성맵 U로 변환

- 스퀴즈(squeeze) : global average pooling (GAP)을 통해 C개 채널의 2차원(HxW)의 특성맵들을 1x1 사이즈의 특성맵으로 변환 (컨볼루션 연산이 local 정보를 다룬다면, 스퀴즈는 global 정보를 다른다)

- 활성화(excitation) : 두 개의 Fully-connected(FC) 층을 더해줘서 각 채널의 상대적 중요도를 알아냄

- 재보정 : C개의 \(S_{c}\)를 \(U_{c}\)에 각각 곱해줘서 U를 재보정.

반응형

'머신러닝_딥러닝 > Object Detection' 카테고리의 다른 글

| (논문리뷰) Yolo v1 (2016) (0) | 2021.09.13 |

|---|---|

| (논문리뷰) Faster R-CNN (0) | 2021.09.13 |

| (논문리뷰) Fast R-CNN (0) | 2021.09.13 |

| (논문리뷰) R-CNN (0) | 2021.09.13 |

| (논문리뷰) DenseNet (0) | 2021.01.15 |